环境配置

大约 2 分钟

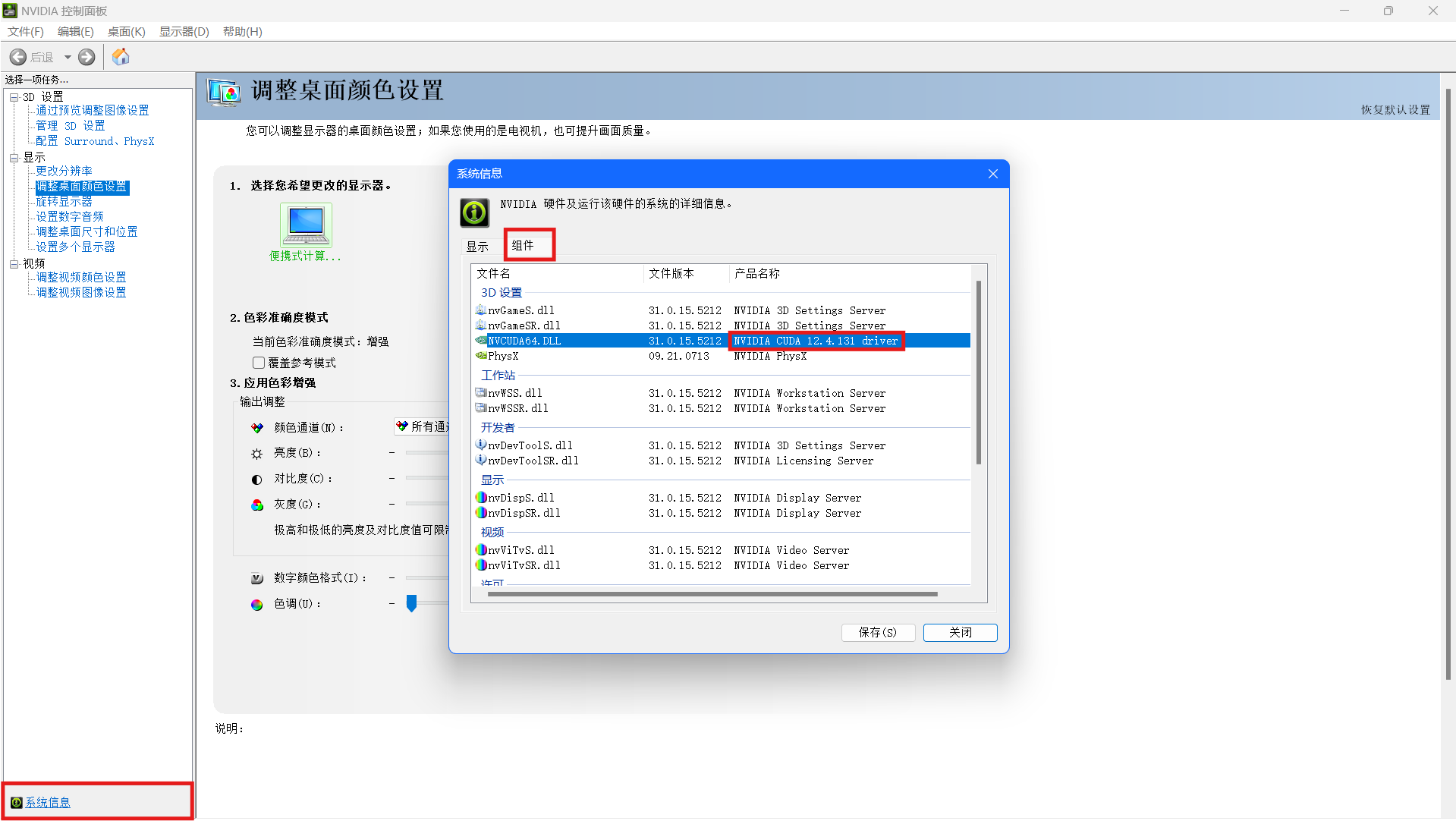

1. 查看 GPU 支持的最高 CUDA 版本

NVDIA 控制面板 -> 左下角系统信息 -> 组件 -> NVCUDA64.DLL产品名称  选择

选择torch版本时选择比该版本号低的版本

2. 下载 cuda

下载链接 cuda 官网 CUDA是一个并行计算平台和编程模型,能够使得使用GPU进行通用计算变得简单和优雅。 nvcc其实就是CUDA的编译器,可以从CUDA Toolkit的/bin目录中获取,类似于gcc就是c语言的编译器。

验证是否安装成功 分别运行

NVIDIA-smi

nvcc -V

分别返回版本号为

CUDA Version: 12.4

Build cuda_12.1.r12.1/compiler.32688072_0

原因: 因为CUDA有两种API,分别是运行时API和驱动API,即所谓的Runtime API与Driver API。nvidia-smi的结果除了有GPU驱动版本型号,还有CUDA Driver API的型号,这里是 11.0。

而nvcc的结果是对应CUDA Runtime API(安装python包(例如torch)需要匹配runtime cuda版本)。

3. 下载 cudnn (CUDA Deep Neural Network library)

一个专门为深度学习计算设计的软件库,里面提供了很多专门的计算函数,如卷积等。

下载链接 cudnn,选择对应版本下载后,解压各个文件(bin、include、lib/x64)下的文件到路径C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.1下的对应文件中去。

4. 下载 torch

下载链接 torch 官网

如果包管理器使用的是清华源可能会下载到cpu版本的torch,会识别不到cuda

运行

import torch

print(torch.__version__)

若返回的版本号带有cpu则表示版本错误,若带有cu121则表示成功

5. 验证

运行

import torch

print(torch.__version__)

print(torch.version.cuda)

print(torch.cuda.is_available())

print(torch.backends.cudnn.version())

返回

2.2.2+cu121 / torch 版本

12.1 / cuda 版本

True / 判断 GPU 是否可用

8801 / NVIDIA cuDNN 版本 8.8.01